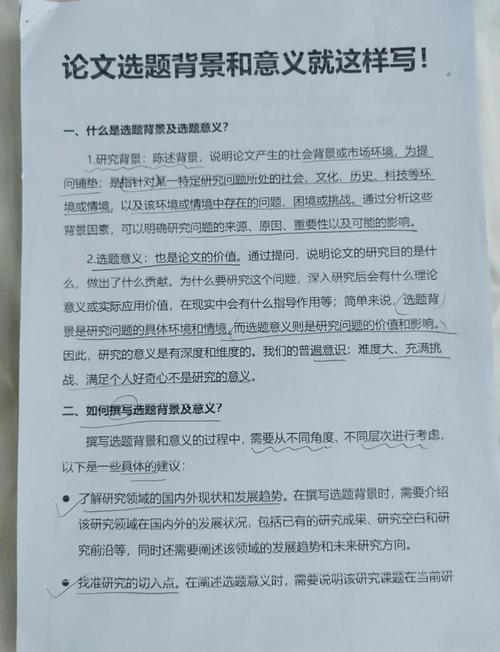

第一部分:课题的提出 (问题的提出)

这部分的核心是“讲一个好故事”,即“发现一个有价值的问题”,你需要层层递进,逻辑清晰地展示你是如何发现这个研究问题的,通常遵循“从大到小,从远到近”的逻辑链条。

写作结构与要点:

宏观背景与现状

- 目的: 将你的研究问题置于一个广阔的社会、经济、文化或技术背景下,说明其时代性和普遍性。

- 描述你所研究领域的宏观发展趋势、政策导向或社会变迁。

- 指出当前该领域取得的成就和普遍存在的现象。

- 写作技巧: 使用“随着……的快速发展”、“在……的背景下”、“近年来,……已成为……的重要议题”等句式。

- 示例: “随着全球数字化转型的浪潮,人工智能技术正以前所未有的速度渗透到社会经济的各个层面,深刻地改变着生产方式和生活方式。”

问题聚焦与矛盾揭示

- 目的: 从宏观背景中聚焦,指出在当前发展进程中出现的矛盾、困境或未被满足的需求,这是从“是什么”到“为什么”的关键一步。

- 指出宏观背景下存在的具体问题、挑战或痛点。

- 描述理论与实践之间的差距、理想与现实之间的矛盾。

- 写作技巧: 使用“在……的过程中,我们发现……”、“……也带来了新的挑战”、“一个不容忽视的问题是……”等转折性词语。

- 示例: “在AI技术快速应用的同时,其数据偏见、算法黑箱、隐私泄露等问题也日益凸显,引发了社会对技术伦理和公平性的广泛担忧。”

研究现状述评 (文献综述的浓缩)

- 目的: 证明你对前人的研究有充分的了解,并在此基础上找到你研究的切入点和创新空间,这体现了研究的学术严谨性。

- 简要回顾国内外学者在该问题上的主要研究成果、代表性观点和采用的研究方法。

- 关键一步: 指出当前研究的不足、空白或争议之处,这正是你的研究将要填补或解决的地方。

- 写作技巧: 使用“已有研究主要集中于……”、“学者们普遍认为……”、“但现有研究仍存在以下不足:”等句式。

- 示例: “国内外学者已从法律、社会学等角度对AI伦理问题进行了诸多探讨,但现有研究多集中于宏观原则的构建,对于具体应用场景(如金融信贷、医疗诊断)中算法偏见如何量化、识别和修正的实证研究尚显不足。”

明确研究问题

- 目的: 在前面层层铺垫的基础上,水到渠成地提出你的具体研究问题,这是整个“问题提出”部分的落脚点。

- 用清晰、简洁、具体的一句话或一个问句,概括你研究的核心内容。

- 问题应具有明确的研究边界,不宜过大或过小。

- 示例: “本研究拟以金融信贷领域的AI风控模型为具体案例,探究如何构建一套有效的算法偏见识别与修正框架。”

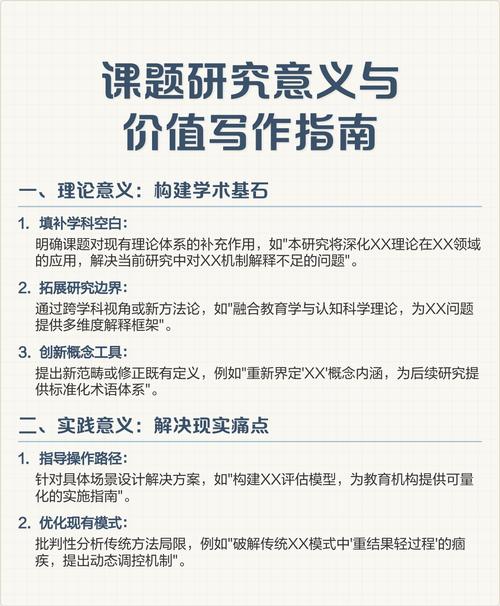

第二部分:研究意义

研究意义分为理论意义和实践意义(或应用价值)两个方面,二者相辅相成,共同构成你研究的价值所在。

理论意义

- 目的: 阐明你的研究将如何推动学术知识的发展,为现有理论体系做出什么贡献。

- 填补理论空白: 是否填补了现有研究的某个空白?是否拓展了某个理论的适用范围?

- 验证或修正理论: 是否通过新的数据或案例验证了某个理论的普适性?或者发现了理论的局限性并提出了修正方向?

- 提出新理论/新视角: 是否在现有研究基础上,提出了新的概念、模型或分析框架?

- 促进学科交叉: 是否融合了不同学科的理论,为交叉学科研究提供了新的思路?

- 写作技巧: 使用“本研究将丰富……理论”、“为……提供了新的分析视角”、“有助于深化对……的理解”等句式。

- 示例: “本研究通过将算法伦理理论与金融学、计算机科学相结合,构建了跨学科的算法偏见分析框架,为数字金融领域的伦理研究提供了新的理论工具。”

实践意义 (或应用价值)

- 目的: 阐明你的研究成果将如何解决现实世界中的具体问题,带来哪些实际效益。

- 对决策者/政策制定者: 研究成果能为政府、企业等机构的决策提供科学依据和参考建议吗?为制定相关行业标准或监管政策提供支持。

- 对行业发展/产业应用: 研究成果能否帮助企业优化流程、提高效率、降低成本、规避风险?本研究提出的框架可以帮助金融机构更公平、更安全地使用AI技术。

- 对社会公众/特定群体: 研究成果能否改善民生、提升公众福祉、促进社会公平?本研究有助于减少因算法偏见导致的社会不公现象。

- 对技术发展: 研究成果能否为技术的健康发展指明方向,推动负责任的创新?

- 写作技巧: 使用“本研究成果可为……提供决策参考”、“有助于……行业解决……难题”、“对于提升……效率、保障……安全具有重要的现实指导意义”等句式。

- 示例: “本研究提出的算法偏见修正框架,可直接应用于金融机构的AI风控系统,有效提升模型的公平性和透明度,帮助企业在追求效率的同时,履行社会责任,赢得公众信任,从而实现可持续发展。”

综合范例

课题: 《金融信贷AI风控模型中的算法偏见识别与修正研究》

课题的提出

随着全球数字化转型的浪潮,人工智能技术正以前所未有的速度渗透到社会经济的各个层面,深刻地改变着生产方式和生活方式,在金融领域,基于机器学习的AI风控模型因其高效、精准的优势,已被广泛应用于信贷审批、风险评估等核心环节,极大地提升了金融服务效率,在AI技术快速应用的同时,其数据偏见、算法黑箱、隐私泄露等问题也日益凸显,引发了社会对技术伦理和公平性的广泛担忧,特别是,如果训练数据中包含了历史性的社会偏见,AI模型可能会无意识地放大这些歧视,对特定人群(如女性、少数族裔)造成不公,这不仅违背了金融普惠的初衷,也可能引发法律风险和声誉危机。

国内外学者已从法律、社会学等角度对AI伦理问题进行了诸多探讨,并提出了公平性、可解释性等原则,但现有研究多集中于宏观原则的构建和定性分析,对于金融信贷这一具体应用场景中,算法偏见如何被量化、识别、追踪以及最终修正的系统性、可操作的实证研究尚显不足,学术界缺乏一个既能连接理论原则又能指导工程实践的桥梁。

本研究拟以金融信贷领域的AI风控模型为具体案例,探究如何构建一套有效的算法偏见识别与修正框架,本研究旨在回答以下核心问题:金融信贷AI风控模型中的算法偏见主要来源于哪些环节?2. 如何利用现有技术指标(如AIF360、Fairlearn等工具包)量化并识别这些偏见?3. 针对不同类型的偏见,应采取何种技术策略进行有效修正,并评估其修正效果?

研究意义

理论意义 本研究将丰富和拓展算法伦理学、金融科技以及计算社会科学的交叉研究,通过在金融信贷这一具体场景下对算法偏见的系统性分析,本研究将深化对“技术-社会”互动关系的理解,为数字时代的金融不平等问题提供新的理论解释,本研究尝试将公平性约束、可解释性等抽象伦理原则,转化为可量化、可操作的工程技术指标和模型修正策略,从而在“伦理原则”与“技术实现”之间搭建起一座理论桥梁,为负责任人工智能(Responsible AI)的理论体系贡献新的实证材料和模型框架。

实践意义 本研究的成果具有直接而重要的应用价值,对金融机构而言,本研究提供了一套完整的算法偏见诊断与“治疗”工具箱,帮助企业在模型开发和应用中主动识别和规避歧视风险,在提升风控效率的同时,确保决策的公平性和透明度,从而增强企业社会责任感和市场竞争力,对监管机构而言,本研究为制定和落地针对AI金融产品的公平性审查标准、监管沙盒等政策提供了科学依据和技术支持,有助于防范系统性金融风险,维护金融市场稳定,对社会公众而言,本研究有助于推动金融服务的真正普惠,减少因算法偏见导致的信贷歧视,保障每一位公民平等获得金融服务的权利,促进社会公平正义。