神经网络的预测应用研究是当前人工智能领域的重要方向,其通过模拟人脑神经元之间的连接机制,对复杂非线性数据进行建模和预测,已在金融、医疗、工业、交通等多个领域展现出巨大潜力,以下从技术原理、核心算法、典型应用场景、挑战与优化方向等方面展开详细分析。

神经网络预测的技术原理与核心优势

神经网络的预测能力源于其多层非线性映射结构,以最常用的前馈神经网络为例,输入层接收特征数据,隐藏层通过激活函数(如ReLU、Sigmoid)引入非线性变换,输出层生成预测结果,训练过程中,网络通过反向传播算法计算损失函数(如均方误差、交叉熵)对各层权重的梯度,并利用优化器(如Adam、SGD)更新权重,最终使模型输出逼近真实值。

与传统统计模型(如线性回归、时间序列ARIMA)相比,神经网络的核心优势在于:

- 强大的非线性拟合能力:能处理高维、非结构化数据(如图像、文本),无需人工设计特征;

- 自动特征学习:通过卷积层(CNN)、循环层(RNN)等结构自动提取数据中的时空特征;

- 端到端建模:直接从原始数据到预测结果,减少中间环节的信息损失。

核心算法与模型架构

针对不同数据特性,神经网络发展出多种专用预测模型:

多层感知机(MLP)

适用于结构化数据的回归与分类预测,在房价预测中,MLP可输入房屋面积、地段、房龄等特征,通过隐藏层的非线性变换输出房价预测值,其局限性在于难以处理序列数据或空间依赖关系。

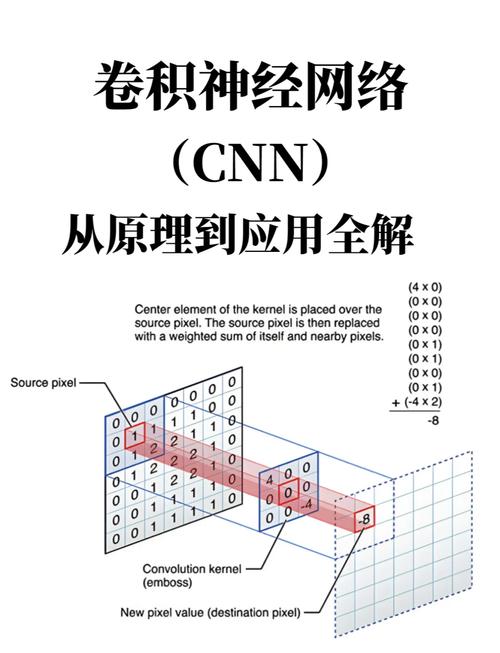

卷积神经网络(CNN)

通过卷积核提取局部特征,广泛应用于图像、视频预测任务,在交通流量预测中,CNN可将路网图像作为输入,识别拥堵区域的空间模式;在气象预测中,可处理卫星云图数据,预测台风路径。

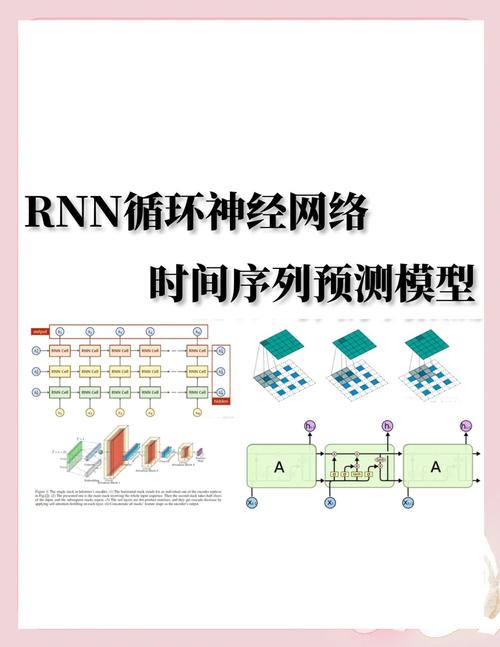

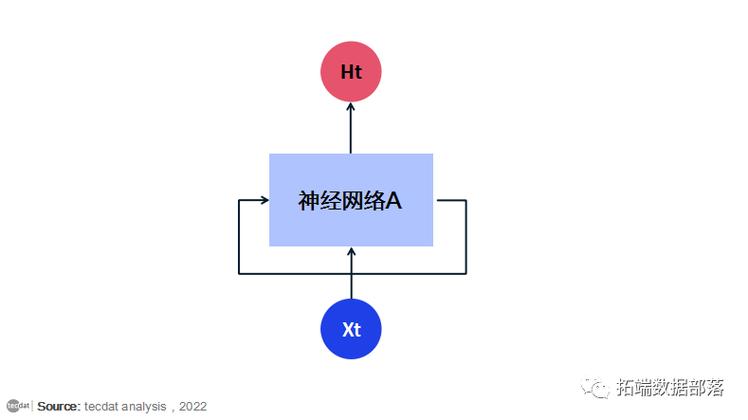

循环神经网络(RNN)及其变体

针对序列数据设计,通过隐藏层状态传递历史信息,长短期记忆网络(LSTM)和门控循环单元(GRU)通过门控机制解决长期依赖问题,成为时间序列预测的主流模型,在股票价格预测中,LSTM可学习历史价格与交易量的时序规律;在电力负荷预测中,可融合温度、节假日等周期性因素。

Transformer模型

基于自注意力机制,并行处理序列数据,克服RNN的串行计算缺陷,在自然语言处理(NLP)领域,Transformer可预测文本情感、机器翻译结果;在多变量时间序列预测中,如空气质量预测,可捕捉不同变量间的动态相关性。

图神经网络(GNN)

适用于图结构数据,通过节点信息聚合和传递进行预测,在社交网络中预测用户流失风险,在分子结构预测中估算化合物性质。

下表对比了主要神经网络模型的特点与适用场景:

| 模型类型 | 核心结构 | 适用数据类型 | 典型预测任务 |

|--------------|--------------------|------------------------|--------------------------------|

| MLP | 全连接层 | 结构化数据 | 房价、销量预测 |

| CNN | 卷积层+池化层 | 网格数据(图像、视频) | 交通流量、气象预测 |

| LSTM/GRU | 循环门控结构 | 序列数据 | 股票价格、电力负荷预测 |

| Transformer | 自注意力机制 | 序列数据 | 文本情感、多变量时间序列预测 |

| GNN | 图卷积/消息传递 | 图结构数据 | 社交网络用户行为、分子性质预测 |

典型应用场景

金融领域

神经网络被广泛用于股票价格预测、信用风险评估和欺诈检测,LSTM模型可融合历史股价、成交量、新闻情绪等多源数据,预测短期股价走势;GAN(生成对抗网络)可生成逼真的金融数据,增强模型在极端市场情况下的鲁棒性。

医疗健康

在疾病预测中,CNN可分析医学影像(如CT、MRI)早期识别肿瘤;RNN可结合患者历史病历、生命体征数据预测疾病进展风险(如糖尿病并发症),神经网络还可预测药物分子活性,加速新药研发。

工业制造

基于工业物联网(IIoT)数据,神经网络可预测设备剩余使用寿命(RUL),通过分析传感器数据(如温度、振动)提前预警故障,降低停机损失,在风电领域,LSTM可预测齿轮箱的故障时间。

交通与城市规划

通过融合实时交通流量、天气、事件数据,CNN-LSTM混合模型可预测未来1小时内的道路拥堵情况;GNN可优化公交线路规划,预测共享单车需求分布。

能源与环境

在电力系统中,Transformer模型可预测短期光伏发电功率,解决新能源并网的波动性问题;在环境领域,神经网络可结合大气污染物浓度、气象数据预测PM2.5浓度变化。

挑战与优化方向

尽管神经网络预测应用广泛,但仍面临以下挑战:

- 数据依赖性:需大量高质量标注数据,而在医疗、工业等领域数据获取成本高,可通过迁移学习(如预训练模型微调)、生成式数据增强(如GAN生成合成数据)缓解。

- 模型可解释性差:深度网络常被视为“黑箱”,影响决策可信度,可引入SHAP值、LIME等可解释性工具,或结合注意力机制可视化关键特征。

- 计算资源消耗大:复杂模型(如Transformer)训练需高性能硬件支持,可通过模型压缩(剪枝、量化)、分布式训练降低算力需求。

- 动态适应能力不足:现实场景数据分布可能漂移(如消费习惯突变),导致模型性能下降,可采用在线学习、持续学习策略,动态更新模型参数。

相关问答FAQs

Q1:神经网络预测与传统机器学习模型(如随机森林、XGBoost)相比,在哪些场景下更具优势?

A:神经网络在处理高维、非结构化数据(如图像、文本、语音)时优势显著,图像识别中的物体定位、自然语言处理中的机器翻译等任务,传统模型难以有效提取特征,当数据存在复杂的非线性关系或长期依赖时(如股票价格预测、语音识别),LSTM、Transformer等神经网络模型能取得更好的预测效果,但对于中小规模结构化数据,传统机器学习模型往往训练更快、可解释性更强,且在数据量有限时不易过拟合。

Q2:如何解决神经网络预测模型在工业场景中的“数据稀缺”问题?

A:工业场景常因设备成本高、故障样本少导致数据稀缺,可通过以下方法解决:(1)迁移学习:将在公开数据集(如NASA轴承数据集)上预训练的模型迁移到特定设备,仅用少量工业数据微调;(2)生成式数据增强:利用GAN或VAE生成与真实数据分布相似的合成故障数据,扩充训练集;(3)无监督/自监督学习:通过对比学习、掩码建模等技术从未标注数据中学习特征,减少对标注数据的依赖;(4)物理模型融合:将工业领域的物理定律(如力学方程、电路原理)作为正则项融入神经网络损失函数,提升数据利用效率。