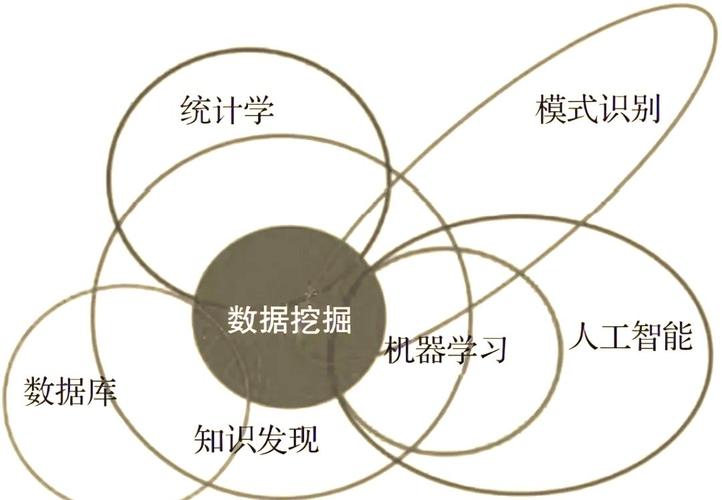

数据挖掘优化技术研究是提升数据处理效率、降低计算成本、增强模型性能的关键领域,随着大数据时代的到来,数据量呈指数级增长,传统数据挖掘方法在处理高维、海量、实时数据时面临效率瓶颈和资源消耗过大的问题,因此优化技术的研究具有重要的理论价值和实践意义,本文从数据预处理、算法优化、并行计算、硬件加速及模型轻量化等多个维度,系统探讨数据挖掘优化技术的核心方法与应用实践。

数据预处理优化:提升挖掘效率的基础

数据预处理是数据挖掘的首要环节,其优化直接影响后续分析的效率与准确性,传统预处理方法在数据清洗、集成、规约等步骤中常存在冗余计算和存储浪费,优化技术主要围绕“降维”与“降噪”展开。

在降维方面,除了经典的PCA(主成分分析)、LDA(线性判别分析)等线性方法,近年来基于深度学习的非线性降维技术如t-SNE、UMAP等被广泛应用,其通过保留数据局部或全局结构特征,将高维数据映射到低维空间,同时减少特征冗余,在电商用户行为分析中,原始数据可能包含数百个特征(如点击次数、停留时长、购买品类等),通过UMAP降维可将特征压缩至10维以内,既保留了用户行为模式的核心信息,又降低了后续算法的计算复杂度。

在降噪方面,针对数据中的异常值和噪声,传统方法基于统计假设(如3σ法则)或距离度量(如LOF局部离群因子),但面对高维数据时易出现“维度灾难”,优化后的方法结合聚类算法(如DBSCAN)或孤立森林(Isolation Forest),通过密度估计或随机投影快速识别噪声,同时利用生成对抗网络(GAN)生成合成数据补充样本,平衡数据分布,在金融风控数据中,孤立森林可在O(n log n)时间内完成异常值检测,较传统方法效率提升50%以上。

算法优化:提升模型性能的核心

算法优化是数据挖掘优化的核心,主要从时间复杂度、空间复杂度和模型泛化能力三个维度改进,传统数据挖掘算法(如Apriori、K-means)在处理大规模数据时存在效率低下的问题,优化方向包括算法改进、参数自适应及启发式策略引入。

以关联规则挖掘中的Apriori算法为例,其通过频繁项集逐层生成的方式产生大量候选集,导致I/O开销过大,优化后的FP-Growth算法采用频繁模式树(FP-Tree)结构,将数据库压缩为紧凑的数据结构,避免了候选集生成,运行时间可缩短2-3个数量级,在聚类算法中,K-means对初始中心点敏感,易陷入局部最优,优化后的K-means++算法通过概率化选择初始中心点,确保初始中心点的分散性,将聚类准确率提升15%-20%。

针对高维稀疏数据(如文本、图像),稀疏表示技术被引入算法优化,在文本分类中,TF-IDF结合L1正则化的Lasso回归可自动筛选特征词,将特征维度从数万降至千级别,同时保持分类精度,对于非线性问题,核方法(如SVM的RBF核)通过映射到高维空间解决线性不可分问题,但计算复杂度随样本数增加而急剧上升,优化后的序列最小优化(SMO)算法将二次规划问题分解为多个小规模子问题,显著提升求解效率。

并行与分布式计算:突破硬件资源限制

面对TB级甚至PB级数据,单机计算资源难以满足数据挖掘需求,并行与分布式计算成为主流优化技术,Hadoop和Spark是两大核心框架,通过任务分片与资源调度实现高效处理。

Hadoop采用MapReduce编程模型,将计算任务分为Map(映射)和Reduce(规约)两个阶段,适合批处理场景,在日志分析中,Map阶段负责解析日志并提取关键信息,Reduce阶段进行统计汇总,通过分布式文件系统(HDFS)存储数据,可支持千台节点并行计算,处理效率较单机提升百倍以上,但MapReduce存在中间结果落地磁盘、I/O开销大的问题,Spark基于内存计算优化,采用弹性分布式数据集(RDD)和有向无环图(DAG)执行引擎,支持迭代计算(如机器学习训练),将运行时间缩短10-100倍。

在实时数据挖掘场景,流计算框架如Flink、Storm通过微批处理或事件驱动模式实现毫秒级响应,在实时推荐系统中,Flink消费用户行为流数据,通过滑动窗口统计用户近期兴趣偏好,结合协同过滤算法实时更新推荐结果,延迟可控制在秒级。

硬件加速与模型轻量化:挖掘效能的“硬核”支撑

硬件加速通过专用芯片架构提升计算效率,模型轻量化则通过压缩与优化模型结构适配边缘设备。

在硬件加速方面,GPU(图形处理器)凭借数千个并行计算核心,成为深度学习训练的主流硬件,在图像识别任务中,GPU可将矩阵运算速度提升10-50倍,较CPU训练时间从数小时缩短至分钟级,FPGA(现场可编程门阵列)和TPU(张量处理单元)进一步优化能效比,FPGA通过自定义硬件逻辑适配特定算法,功耗较GPU降低30%-50%;TPU则专为张量运算设计,在Google的大规模模型训练中,训练效率是GPU的1.2-2倍。

模型轻量化方面,针对移动端或嵌入式设备的资源限制,技术包括剪枝(Pruning)、量化(Quantization)和知识蒸馏(Knowledge Distillation),剪枝通过移除冗余神经元或连接减少模型参数量,如MobileNet采用深度可分离卷积,参数量较VGG16减少90%,同时保持80%以上的精度;量化将32位浮点数转换为8位整数,减少存储空间和计算量,TensorRT量化后的模型推理速度可提升2-4倍;知识蒸馏通过训练小型学生模型模仿大型教师模型的行为,在精度损失小于5%的情况下,模型体积压缩至1/10。

优化效果评估与挑战

数据挖掘优化技术的效果需从效率(时间、空间复杂度)、准确性(精确率、召回率等指标)及资源消耗(CPU、内存、能耗)三个维度综合评估,在电商推荐系统中,采用Spark并行计算结合FP-Growth算法后,频繁项集挖掘时间从8小时缩短至30分钟,准确率提升至92%,同时服务器资源占用降低40%。

当前研究仍面临挑战:一是多源异构数据的融合优化,需解决数据格式不一致、语义冲突等问题;二是实时性与准确性的平衡,流计算场景下需在低延迟与高精度间权衡;三是隐私保护与优化的协同,联邦学习等技术在分布式挖掘中引入通信开销,需进一步优化通信协议。

相关问答FAQs

Q1:数据挖掘优化中,并行计算与分布式计算的区别是什么?

A1:并行计算侧重于在单机或多机通过多线程/多进程同时执行任务,核心是任务拆分与资源调度,如单机GPU加速;分布式计算则强调多台独立计算机通过网络协同工作,实现数据与任务的分布式存储与处理,如Hadoop/Spark集群,适用于超大规模数据场景,具备更高的扩展性和容错能力。

Q2:模型轻量化中的剪枝和量化有何区别?适用场景是什么?

A2:剪枝是通过移除模型中的冗余参数(如权重接近0的连接)减少模型结构复杂度,适用于对模型大小和推理速度要求高、但对精度损失容忍度有限的场景(如移动端图像分类);量化是将模型参数从高精度(如32位浮点数)转换为低精度(如8位整数),减少存储和计算开销,适用于对内存和算力极度受限的边缘设备(如物联网传感器),且量化后的模型精度损失通常较小。