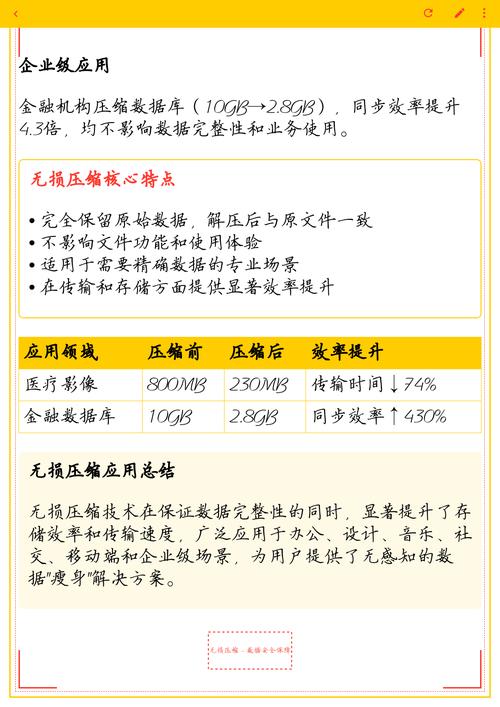

无损压缩算法是数据压缩技术中的重要分支,其核心目标是在不丢失任何原始信息的前提下,通过消除数据中的冗余来减少数据存储空间或传输带宽,与有损压缩不同(如JPEG、MP3等会牺牲部分质量换取更高压缩率),无损压缩广泛应用于文本、程序代码、医学影像、金融数据等对准确性要求极高的领域,本文将探讨无损压缩算法的基本原理、主流技术分类、性能评估指标及未来发展趋势。

无损压缩算法的底层逻辑基于数据的冗余特性,冗余可分为时间冗余(如视频连续帧间的相似性)、空间冗余(如图像相邻像素的关联性)、编码冗余(如数据中频繁出现的符号未用短码表示)和知识冗余(如规律性数据可被模型描述),通过数学模型对冗余进行识别与编码,可实现数据量的精简,文本中字母“e”出现频率远高于“z”,若为“e”分配1位二进制码、“z”分配8位,整体存储需求将显著降低。

主流无损压缩算法分类与技术特点

基于统计的压缩算法

此类算法通过统计符号出现频率构建编码表,实现对高频符号的短码表示和低频符号的长码表示,典型代表包括:

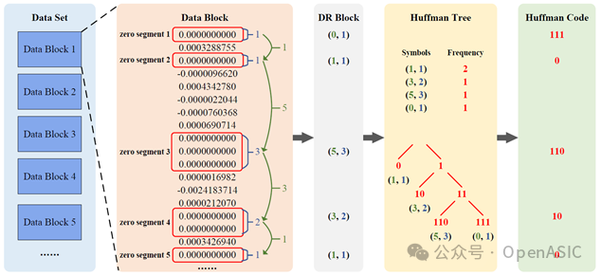

- 霍夫曼编码(Huffman Coding):1952年由David Huffman提出,通过构建最优二叉树(霍夫曼树)为符号分配变长码字,确保无前缀码(即任一码字不是其他码字的前缀),其压缩率取决于符号分布的离散程度,分布越不均匀,压缩效果越好,但霍夫曼编码需预先统计频率,对动态数据适应性较弱。

- 算术编码(Arithmetic Coding):与霍夫曼编码的离散码字不同,算术编码将整个数据序列映射为[0,1)区间内的一个浮点数,用更少的比特表示,字符串“abc”若概率分布为a=0.5、b=0.3、c=0.2,可编码为0.012(二进制),精度随数据长度增加而提升,算术编码压缩率通常优于霍夫曼编码,但计算复杂度更高。

基于字典的压缩算法

字典类算法通过“匹配-替换”机制,用短码(指针)表示重复出现的字符串片段,适用于数据中存在大量重复模式的情况(如文本、程序代码)。

- LZ77算法:由Abraham Lempel和Jacob Ziv于1977年提出,采用“滑动窗口+前向缓冲区”结构,窗口内保存已处理数据,缓冲区为待处理数据,算法在窗口中查找与缓冲区匹配的最长字符串,输出(距离,长度, 下一个字符)的三元组,字符串“ABRACADABRA”中,“ABRA”第二次出现时,可输出(0,4,'C')表示从开头偏移0处取4个字符“ABRA”,后跟字符'C'。

- LZ78算法:LZ77的改进版,通过动态构建字典(树形结构),将新字符串拆分为“已存在的字典项+新字符”进行编码,其衍生算法LZW(Lempel-Ziv-Welch)进一步简化了字典管理,成为GIF、TIFF等图像格式的压缩标准。

预测编码与变换编码

- 预测编码:通过建立数据预测模型(如线性预测、多项式拟合),估计当前值与预测值的差分(预测误差),对误差进行无损编码,由于原始数据通常具有强相关性(如音频采样值、像素灰度),预测误差的熵值远小于原始数据,压缩效率较高,典型应用包括FLAC(Free Lossless Audio Codec)音频压缩。

- 整数小波变换:虽常用于有损压缩,但整数小波变换可实现完全可逆的无损变换,通过将信号分解为不同频率子带,对能量集中的低频子带重点编码,高频子带量化后(无损情况下不量化)进行熵编码,可进一步提升压缩率,JPEG 2000标准支持无损模式,即采用整数小波变换。

无损压缩算法的性能评估

衡量无损压缩算法性能的核心指标包括:

- 压缩率(Compression Ratio):原始数据大小与压缩后数据大小的比值,通常以百分比表示,压缩率越高,算法性能越好。

- 压缩/解压速度:尤其在实时传输场景(如视频会议、远程桌面),速度是关键考量因素。

- 内存占用:字典类算法(如LZW)需存储字典,内存占用随数据量增长而增加,对嵌入式设备不友好。

- 适应性:对数据类型(文本、二进制、图像)的适应能力,以及对动态数据流(如实时音频)的实时编码能力。

下表对比了主流无损压缩算法的典型性能:

| 算法类型 | 代表算法 | 压缩率(典型值) | 压缩速度 | 解压速度 | 内存占用 | 适用场景 |

|---|---|---|---|---|---|---|

| 统计编码 | 霍夫曼编码 | 中(2:1-5:1) | 快 | 快 | 低 | 文本、简单图像 |

| 统计编码 | 算术编码 | 高(3:1-10:1) | 中 | 中 | 中 | 医学影像、高精度数据 |

| 字典编码 | LZ77/LZ78 | 中高(2:1-8:1) | 快 | 极快 | 中 | 程序代码、归档文件 |

| 预测编码 | FLAC | 中(1.5:1-3:1) | 中 | 快 | 低 | 无损音频 |

| 变换编码 | JPEG 2000 | 高(2:1-20:1) | 慢 | 中 | 高 | 医学影像、遥感数据 |

未来发展趋势

随着物联网、5G和人工智能的发展,无损压缩算法面临新的挑战与机遇:

- 智能压缩模型:结合机器学习(如神经网络)构建数据分布预测模型,动态优化编码策略,通过训练模型识别特定数据(如基因组序列)的冗余模式,实现定制化压缩。

- 硬件加速:针对FPGA、GPU等硬件平台优化算法,提升压缩/解压速度,LZ77算法的字符串匹配可通过并行计算硬件(如CUDA)加速。

- 轻量化与边缘计算:针对边缘设备(如传感器、手机)的算力限制,开发低复杂度、低内存占用的压缩算法,支持端侧实时压缩与传输。

- 跨模态压缩:研究多源数据(如图像+文本、音频+传感器数据)的联合压缩,通过模态间冗余消除进一步提升压缩率。

相关问答FAQs

Q1:无损压缩算法是否适用于所有类型的数据?

A1:并非如此,无损压缩的效率取决于数据中的冗余程度,对于随机性高、冗余少的数据(如加密文件、噪声音频),无损压缩可能无法有效压缩,甚至因添加编码信息导致压缩后体积增大(一个完全随机的1MB文件压缩后可能变为1.1MB),这类数据更适合直接存储或采用有损压缩(若允许质量损失)。

Q2:如何选择合适的无损压缩算法?

A2:选择算法需综合考虑数据类型、应用场景和性能需求:

- 文本/程序代码:优先选择字典类算法(如LZ77、LZW),因其对重复字符串压缩效率高;

- 高精度图像/医学影像:推荐算术编码或整数小波变换(如JPEG 2000),可保证像素级无损且压缩率较高;

- 实时音频/视频流:需平衡速度与压缩率,预测编码(如FLAC)或改进的LZ77算法(如LZ4)更合适;

- 嵌入式设备:选择低内存、低复杂度的算法(如霍夫曼编码、简化版LZ77),避免因资源不足导致性能下降。