统计作为数据科学的核心工具,在现代社会治理、经济发展、科学研究等领域发挥着不可替代的作用,随着数据规模的爆炸式增长、数据类型的多样化以及应用场景的复杂化,统计实践过程中面临着一系列亟待解决的问题,这些问题不仅影响统计结果的准确性和可靠性,也可能导致决策偏差,甚至引发社会信任危机,深入分析统计面临的问题并探索解决路径,对于提升统计工作的质量和效率具有重要意义。

当前统计面临的问题首先体现在数据层面,数据质量是统计分析的基础,但现实中“数据垃圾”现象普遍存在,数据缺失、重复、异常值等问题频发,例如在人口普查中,部分群体可能因隐私顾虑或流动性大导致信息填报不全,造成样本偏差;在电商交易数据中,刷单行为会产生大量虚假交易记录,扭曲消费趋势分析,数据来源的多样性也增加了质量控制难度,政府部门、企业、物联网设备等不同主体产生的数据在标准、格式上存在差异,整合过程中易产生“数据孤岛”,影响数据的完整性和一致性,据某研究机构统计,超过60%的企业认为数据质量问题严重制约了统计分析的准确性。

统计方法的应用面临适应性的挑战,传统统计方法多基于假设数据服从特定分布(如正态分布)且样本独立同分布,但在大数据时代,这些假设往往难以成立,在社交媒体文本分析中,数据具有高维度、稀疏性和非结构化特点,传统回归模型难以有效处理;在金融风险建模中,极端事件(如金融危机)的发生打破了数据的平稳性,导致基于历史数据的统计推断失效,机器学习等新兴算法虽然复杂度高、拟合能力强,但存在“黑箱”问题,可解释性差,使得统计结果的透明度和可信度受到质疑,某银行采用深度学习模型进行信用评分,但无法向客户说明具体扣分原因,引发了公平性质疑。

第三,统计伦理与隐私保护问题日益凸显,统计工作常涉及个人隐私、商业秘密等敏感信息,如何在数据利用与隐私保护之间取得平衡成为难题,数据匿名化处理可能导致信息失真,影响统计精度;若匿名化不彻底,则可能通过数据关联攻击重新识别个人身份,2025年某研究机构发布的匿名化浏览历史数据,仅通过结合公开的Facebook点赞数据,就能成功识别用户身份,统计结果可能被滥用,例如在就业歧视中,若统计模型历史上存在性别偏见,可能导致女性求职者被系统性排除,这种“算法歧视”违背了统计伦理的核心原则。

第四,统计人才的能力结构亟待优化,传统统计人才擅长理论建模和数据处理,但在面对跨领域复杂问题时,往往缺乏行业知识和数据技能,在医疗统计中,统计人员若不了解临床诊疗流程,可能设计出有偏倚的研究方案;在工业互联网中,若不熟悉传感器数据特性,则难以构建有效的质量监控模型,统计教育与产业需求存在脱节,高校课程设置偏重理论,对Python、SQL、大数据工具(如Hadoop、Spark)的实践训练不足,导致毕业生难以快速适应岗位要求,据调查,超过70%的统计相关企业认为,复合型统计人才的供给严重不足。

第五,统计结果的传播与解读存在偏差,统计报告往往包含大量专业术语和复杂图表,非专业人士难以准确理解,容易产生误读,将“相关性”等同于“因果性”是常见误区,某地区冰淇淋销量与溺水人数的相关性曾被错误解读为“吃冰淇淋导致溺水”,而实际上两者均受气温影响,部分机构为迎合特定利益,可能选择性呈现统计结果,通过操纵样本范围、调整模型参数等方式制造“数据美化”,这种统计操纵行为严重损害了公信力,某企业在宣传中刻意突出产品满意度调查中的正面数据,隐瞒负面反馈,误导消费者。

为应对上述挑战,需要从多方面入手:一是加强数据治理,建立全生命周期的数据质量管理体系,推广数据溯源技术;二是推动统计方法创新,发展适用于高维、非结构化数据的稳健统计方法,增强机器学习模型的可解释性;三是完善法律法规,制定数据隐私保护标准,规范统计伦理准则;四是改革统计教育,培养“统计+行业+技术”的复合型人才;五是提升公众统计素养,推广可视化、通俗化的统计传播方式,减少信息误读。

相关问答FAQs

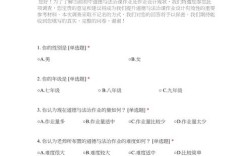

Q1:如何解决统计数据中的缺失值问题?

A:处理缺失值需根据缺失机制(完全随机随机、随机非随机、非随机)选择合适方法,常见策略包括:删除法(若缺失比例低且随机,可直接删除含缺失值的样本);插补法(如均值/中位数插补适用于数值型数据,多重插补通过模拟生成多个完整数据集并整合结果);模型法(利用回归、决策树等模型预测缺失值,适用于非随机缺失),可通过增加样本量、优化数据收集流程从源头减少缺失。

Q2:统计中“相关性不等于因果性”的含义是什么?

A:相关性指两个变量之间存在统计关联(如同步变化),但未必存在因果关系,研究发现“每天吃早餐的人更健康”,这可能是早餐导致健康,也可能是健康习惯好的人更注重早餐,或存在第三方变量(如运动习惯)同时影响两者,要验证因果关系,需通过随机对照试验(RCT)、工具变量法、断点回归等方法排除混杂因素,误将相关性当作因果性会导致错误决策,因此在统计解读中需谨慎区分。