神经网络的分类方法研究是机器学习领域的核心议题之一,随着深度学习技术的快速发展,分类方法在图像识别、自然语言处理、医疗诊断等领域展现出强大的应用潜力,神经网络通过模拟人脑神经元之间的连接机制,能够自动学习数据中的复杂特征,从而实现高效分类,本文将从传统神经网络到深度学习模型,系统梳理神经网络的分类方法及其发展脉络。

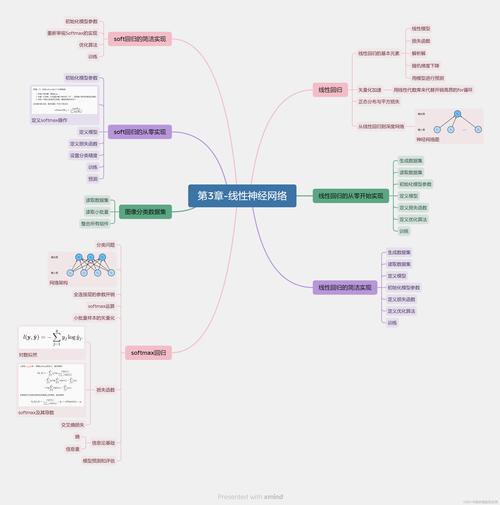

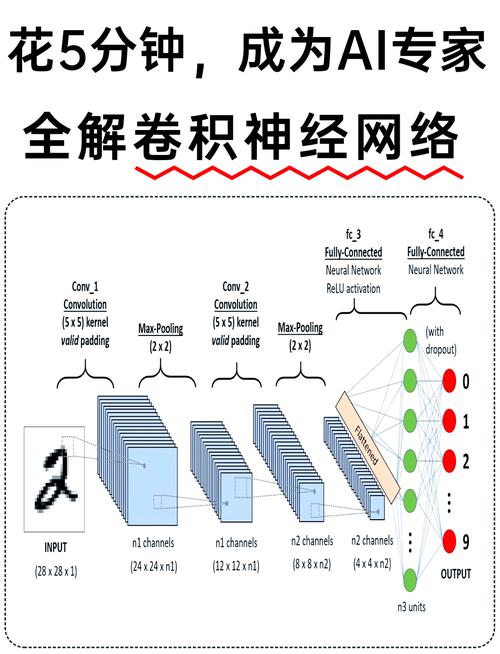

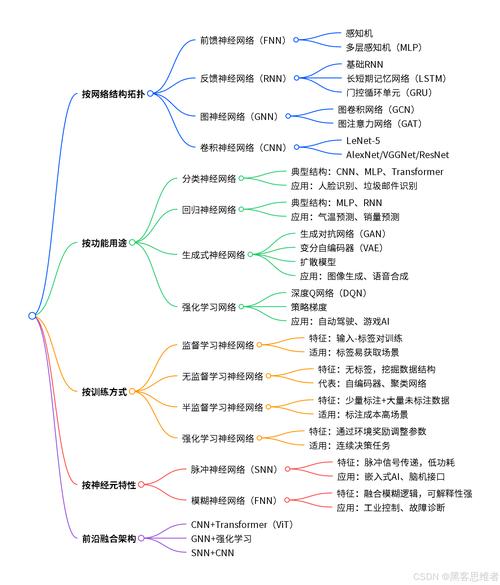

神经网络的分类方法可依据网络结构、学习任务、数据类型等多维度进行划分,从结构角度看,神经网络可分为前馈神经网络、反馈神经网络和循环神经网络三大类,前馈神经网络是最基础的架构,信息单向输入至输出,不形成环路,典型代表包括多层感知机(MLP)、卷积神经网络(CNN)和Transformer,CNN通过卷积层和池化层提取空间特征,在图像分类任务中表现卓越;Transformer则依赖自注意力机制,擅长处理序列数据,成为自然语言处理领域的主流模型,反馈神经网络包含反馈连接,如玻尔兹曼机,能够通过能量函数建模数据分布,但训练复杂度较高,循环神经网络(RNN)及其变体(如LSTM、GRU)则专门处理序列数据,通过隐藏层状态传递历史信息,适用于语音识别、时间序列预测等任务。

从学习任务角度,神经网络的分类方法可分为监督学习、无监督学习和半监督学习,监督学习是最常见的形式,通过标注数据训练网络,输出层通常采用Softmax函数实现多分类,如ResNet在ImageNet竞赛中通过残差连接大幅提升了分类精度,无监督学习则无需标注数据,通过自编码器、生成对抗网络(GAN)等模型学习数据分布,例如GAN可用于异常检测中的分类任务,半监督学习结合少量标注数据与大量无标注数据,降低了对标注成本的依赖,如伪标签法通过高置信度预测结果扩充训练集。

针对不同数据类型,神经网络分类方法各有侧重,结构化数据多采用MLP或图神经网络(GNN),GNN通过节点聚合操作处理图结构数据,在社交网络推荐、分子性质预测等领域效果显著,非结构化数据则依赖特定网络结构:图像数据优先选择CNN或Vision Transformer(ViT);文本数据常使用BERT、GPT等预训练语言模型;语音数据则结合CNN与RNN,如WaveNet模型,多模态数据分类成为研究热点,通过跨模态注意力机制融合文本、图像、语音等信息,如CLIP模型实现了零样本分类能力。

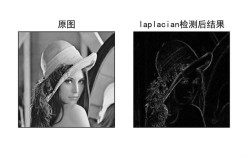

近年来,神经网络分类方法的发展呈现出三大趋势:一是模型轻量化,如MobileNet通过深度可分离卷积减少参数量,适配移动端部署;二是可解释性增强,如Grad-CAM通过可视化热力图解释分类依据,提升模型可信度;三是小样本学习,如原型网络通过度量学习实现少样本分类,缓解数据稀缺问题,尽管取得了显著进展,神经网络分类仍面临过拟合、计算资源消耗大、对抗样本脆弱等挑战,未来研究需结合迁移学习、联邦学习等技术进一步提升模型的泛化能力和实用性。

相关问答FAQs:

-

问:神经网络分类方法与传统机器学习分类方法(如SVM、随机森林)的主要区别是什么?

答:神经网络分类方法与传统方法的核心区别在于特征提取的自动化程度,传统方法依赖人工设计特征(如SVM的核函数映射),而神经网络通过多层结构自动学习数据的高维抽象特征,尤其适合处理图像、语音等复杂非结构化数据,神经网络通常需要更大的数据量和计算资源,但在数据充足时能实现更高的分类精度,尤其在深度学习模型中表现突出。 -

问:如何解决神经网络分类中的过拟合问题?

答:解决过拟合问题可从数据、模型和训练三个层面入手,数据层面可通过数据增强(如图像旋转、裁剪)扩充训练集,或使用正则化技术(如Dropout、权重衰减)限制模型复杂度;模型层面可采用早停法(Early Stopping),在验证集性能下降时终止训练;训练层面可引入批量归一化(Batch Normalization)加速收敛并减少对初始化的依赖,迁移学习通过预训练模型微调,也能有效缓解小样本场景下的过拟合风险。