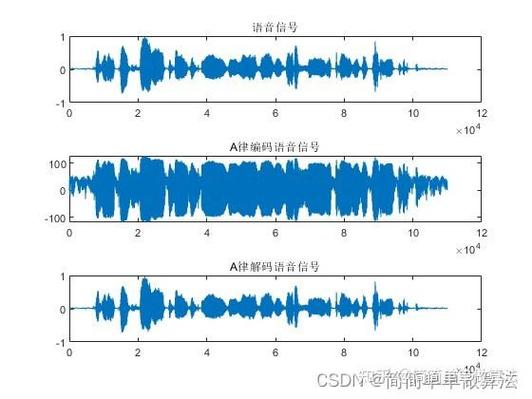

语音信号增强作为语音处理领域的重要研究方向,旨在从含噪语音中提取或恢复纯净语音信号,提升语音质量与可懂度,其研究现状随着深度学习与信号处理技术的融合不断深化,当前研究主要围绕传统方法、基于深度学习的方法及多模态融合方法展开,并逐渐向轻量化、实时化、场景自适应方向发展。

传统语音增强方法以信号处理理论为基础,主要包括谱减法、维纳滤波、统计模型法等,谱减法通过估计噪声谱并从含噪语音谱中减去,实现噪声抑制,但易产生“音乐噪声”失真;维纳滤波基于最小均方误差准则,在平稳噪声环境下性能优越,但对非平稳噪声适应性较差;统计模型法则利用高斯混合模型(GMM)或隐马尔可夫模型(HMM)建模语音与噪声的统计特性,通过贝叶斯估计实现增强,但模型训练复杂度高且对噪声类型依赖性强,传统方法的优势在于计算复杂度低、实时性好,但难以解决非线性噪声、低信噪比(SNR)场景下的增强问题,尤其在复杂声学环境中性能显著下降。

随着深度学习的发展,基于神经网络的语音增强方法成为研究热点,大致可分为基于深度神经网络(DNN)、循环神经网络(RNN)、卷积神经网络(CNN)及Transformer的模型,早期DNN方法通过学习含噪语音到纯净语音的映射关系,直接估计时频掩码(如理想比值掩码IRMA、理想幅度掩码IAM),在平稳噪声下表现优于传统方法,但对长时依赖建模能力不足,RNN及其变体(如LSTM、GRU)引入时序建模能力,能有效捕捉语音信号的动态特性,适合处理非平稳噪声,但训练耗时较长且易出现梯度消失问题,CNN凭借局部感受野和参数共享特性,在提取语音频谱的局部特征与空间相关性方面具有优势,常与DNN/RNN结合构建混合模型(如CRN),进一步提升增强效果,近年来,Transformer模型凭借自注意力机制在长距离依赖建模上的突破,被引入语音增强领域,如Conv-TasNet通过全卷积网络和时域掩码实现端到端增强,避免了传统时频转换带来的信息损失,在低SNR场景下表现出色,生成对抗网络(GAN)的应用通过判别器与生成器的对抗训练,显著增强了语音的自然度,减少了音乐噪声;而自监督学习方法(如wav2vec 2.0)利用无标注数据预训练模型,缓解了对大量标注数据的依赖,提升了模型的泛化能力。

当前研究趋势还体现在轻量化与实时化部署,传统深度学习模型参数量大、计算复杂度高,难以在嵌入式设备或移动终端实时运行,为此,研究者提出模型压缩技术(如剪枝、量化、知识蒸馏),以及轻量级网络结构设计(如MobileNet、ShuffleNet的变体),在保持性能的同时降低计算开销,TDNN(时间延迟神经网络)和轻量级CNN-RNN混合模型在嵌入式平台实现了实时语音增强,满足智能穿戴设备、助听器等场景的需求。

多模态融合是另一重要方向,通过结合视觉信息(如唇动)、声源定位、空间音频等多源数据,提升增强鲁棒性,在视频会议场景中,结合唇部运动的视听融合模型能有效分离说话人语音与背景噪声;麦克风阵列技术则利用波束形成与深度学习结合,实现声源定向增强,抑制空间干扰噪声,场景自适应增强成为研究重点,通过无监督或半监督学习,使模型能够实时适应未知噪声类型或环境变化,如基于元学习的快速噪声适应框架,在少量样本即可完成模型调整。

语音增强仍面临诸多挑战:一是极端噪声环境(如强冲击噪声、多人说话干扰)下的增强效果有限;二是低延迟要求与高性能之间的平衡问题,尤其在实时通信场景中;三是客观评价指标(如PESQ、STOI)与主观感知(自然度、舒适度)的不一致,需进一步探索更贴合人耳感知的评价体系;四是模型的可解释性不足,难以明确增强过程中的噪声抑制机制与语音失真来源。

相关问答FAQs

Q1:语音增强中传统方法与深度学习方法的主要区别是什么?

A1:传统方法基于信号处理理论(如谱减、维纳滤波),依赖噪声统计特性和先验假设,计算简单但适应性差,尤其在非平稳噪声和低信噪比场景下性能有限;深度学习方法通过神经网络从数据中学习语音与噪声的复杂映射关系,能处理非线性噪声、长时依赖问题,增强效果显著提升,但需大量标注数据训练,计算复杂度较高,且对实时部署有一定挑战,两者结合(如传统方法作为预处理或辅助模块)可发挥各自优势。

Q2:当前语音增强研究面临的主要挑战有哪些?

A2:主要挑战包括:①极端噪声环境(如强背景噪声、多人干扰)下的鲁棒性不足;②实时性与高性能的平衡,延迟过高影响用户体验;③客观评价指标(如PESQ)与主观感知(自然度)的差异,缺乏统一评价标准;④模型泛化能力弱,对未知噪声类型或环境变化适应性差;⑤轻量化部署困难,嵌入式设备算力难以支撑复杂深度学习模型;⑥可解释性不足,难以分析增强决策的依据与潜在失真风险。