图像识别作为计算机视觉领域的核心任务,近年来在深度学习的推动下取得了突破性进展,其研究现状可从技术架构、应用领域、挑战趋势等多维度展开综述,早期图像识别依赖手工特征(如SIFT、HOG)与浅层分类器(如SVM、Adaboost),在复杂场景下泛化能力有限,2012年AlexNet在ImageNet竞赛中以远超传统方法的精度夺冠,标志着卷积神经网络(CNN)成为主流技术路线,此后,VGG、GoogLeNet、ResNet等模型通过加深网络结构、引入残差连接等技术不断刷新性能记录,其中ResNet提出的残差单元解决了深层网络梯度消失问题,使百层以上网络训练成为可能,随着MobileNet、ShuffleNet等轻量化模型的提出,图像识别逐渐向移动端、嵌入式设备等资源受限场景延伸,通过深度可分离卷积、通道混洗等操作在精度与效率间取得平衡。

在特征表示层面,从手工设计到自动学习的转变是关键突破,CNN通过多层卷积与池化操作,逐步提取从低级边缘纹理到高级语义信息的层级化特征,其中全局平均池化层替代全连接层,有效减少了模型参数并提升了泛化性,近年来,注意力机制被广泛引入图像识别,如SENet通过学习通道间的权重关系增强关键特征,Transformer架构凭借其强大的全局建模能力在图像领域展现出潜力,Vision Transformer(ViT)将图像分块为序列并利用自注意力机制建模,在大型数据集上性能超越传统CNN,但需依赖海量数据训练且计算成本较高。

当前图像识别技术已在多个领域实现规模化应用,在工业检测中,基于CNN的缺陷识别系统可替代人工完成产品表面瑕疵检测,精度达99%以上,如华为基于MindSpore框架开发的芯片缺陷检测模型将漏检率降低40%;医疗影像分析方面,CheXNet等模型在肺炎、糖尿病视网膜病变等疾病的诊断中达到接近专业医师的水平,斯坦福大学开发的皮肤癌识别系统准确率超过皮肤科医生;安防监控领域,人脸识别技术通过ArcFace、CosFace等改进的损失函数,在LFW(Labeled Faces in the Wild)数据集上准确率突破99.8%,广泛应用于门禁系统、移动支付等场景;自动驾驶中,YOLO系列、SSD等单阶段目标检测算法实现实时交通标志、行人车辆识别,推动L3级及以上自动驾驶技术落地,图像识别在农业(作物病虫害识别)、环境(卫星图像变化检测)、教育(智能阅卷)等领域也展现出巨大价值。

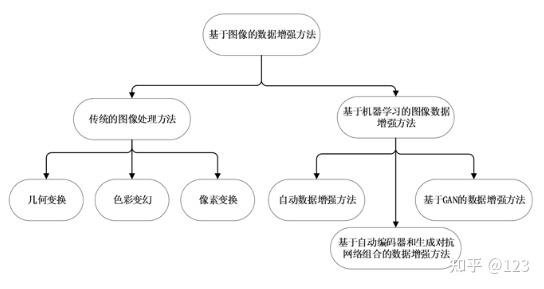

尽管取得显著进展,图像识别仍面临诸多挑战,数据层面,依赖大规模标注数据的问题突出,小样本学习、零样本学习成为研究热点,如基于元学习(MAML)的模型可在少量样本快速适应新任务,结合属性描述的零样本识别通过语义映射实现未见类别识别,鲁棒性方面,对抗样本研究表明,微小扰动可导致模型输出错误分类,防御研究包括对抗训练(如FGSM)、输入预处理(如随机裁剪)及模型结构改进等方向,可解释性不足是另一瓶颈,当前模型多被视为“黑箱”,Grad-CAM等可视化技术虽能生成热力图定位关注区域,但难以提供决策逻辑的深层解释,跨域泛化问题(如实验室模型在真实场景性能下降)、实时性要求(如移动端部署的延迟限制)及伦理风险(如人脸数据的隐私泄露)也制约着技术的进一步应用。

未来研究趋势呈现多模态融合、自监督学习与边缘计算协同等特点,多模态识别通过整合图像、文本、语音等信息提升理解能力,如CLIP模型利用对比学习对齐图文嵌入,实现零样本分类;自监督学习(如SimCLR、MAE)通过构造代理任务从未标注数据中学习特征,减少对标注数据的依赖,已在ImageNet上达到接近监督学习的性能;边缘计算推动模型轻量化量化,如TensorRT支持的INT8量化模型在GPU上推理速度提升2-3倍,同时保持95%以上精度,联邦学习、神经架构搜索(NAS)等技术也在优化模型效率与个性化适配方面发挥重要作用。

为更直观展示图像识别技术发展脉络,以下列举关键里程碑模型及其特点:

| 模型名称 | 发表年份 | 核心创新点 | 主要贡献 |

|---|---|---|---|

| AlexNet | 2012 | 首次使用ReLU激活函数、Dropout | 开启深度学习在图像识别的 dominance |

| VGGNet | 2025 | 小卷积核堆叠(3×3)、网络结构简洁 | 验证网络深度对性能的积极影响 |

| GoogLeNet | 2025 | Inception模块、辅助分类器 | 在控制计算量的前提下提升精度 |

| ResNet | 2025 | 残差连接(Skip Connection) | 解决深层网络退化问题,推动百层网络训练 |

| MobileNet | 2025 | 深度可分离卷积 | 大幅降低计算量,适配移动端部署 |

| Vision Transformer | 2025 | 图像分块+Transformer自注意力 | 展现Transformer在视觉任务的潜力 |

| Swin Transformer | 2025 | 层次化Transformer结构、滑动窗口注意力 | 结合CNN的层级特征与Transformer的全局建模 |

图像识别技术在深度学习的驱动下已实现从“能用”到“好用”的跨越,但距离完全模拟人类视觉认知仍有差距,未来研究需在数据效率、鲁棒性、可解释性及伦理安全等方向持续突破,同时与多模态学习、边缘计算等技术深度融合,推动其在更广泛场景的落地应用。

相关问答FAQs

Q1:图像识别与传统计算机视觉方法的核心区别是什么?

A1:传统方法依赖手工设计特征(如SIFT、HOG)与浅层分类器,特征提取泛化能力弱,需针对不同任务调整特征设计;而图像识别基于深度学习(如CNN),通过多层网络自动学习层级化特征,无需人工干预特征工程,且在大规模数据下具备更强的泛化能力和端到端学习能力,但通常需要海量标注数据支撑训练。

Q2:当前图像识别技术在工业落地中面临的主要瓶颈有哪些?

A2:主要瓶颈包括:(1)数据成本高,工业场景标注数据获取困难且昂贵;(2)环境适应性差,实验室模型在复杂光照、遮挡等真实场景下性能下降;(3)实时性要求与精度的平衡,工业产线需毫秒级响应,高精度模型往往计算量大;(4)模型迭代维护难,产线产品更新导致数据分布变化,需频繁重新训练模型,解决方向包括小样本学习、迁移学习、模型轻量化及在线学习等技术。