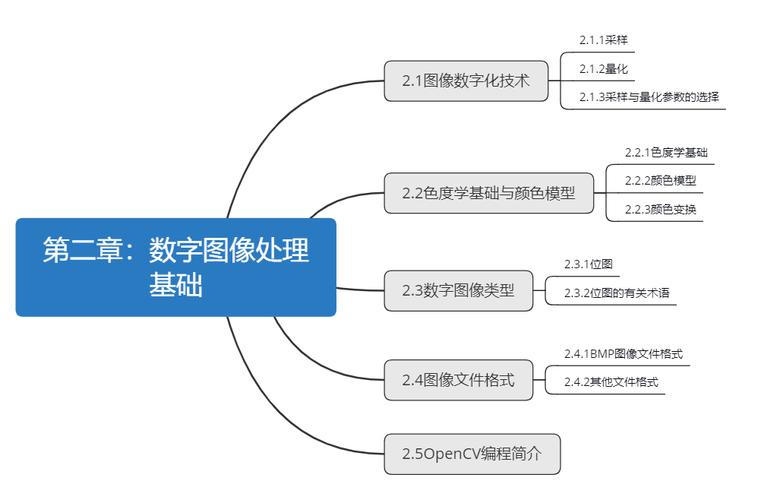

数字图像处理作为一门融合了数学、计算机科学、光学等多学科知识的交叉学科,其研究方法体系随着技术发展不断丰富和完善,当前,数字图像处理的研究方法主要涵盖理论建模、算法设计、实验验证及系统实现等多个维度,通过系统化的研究流程推动图像处理技术在医疗影像、自动驾驶、安防监控等领域的深度应用。

基于数学理论的建模与分析方法

数学理论是数字图像处理研究的基石,为图像信号的表示、变换与理解提供了形式化工具,在图像增强与复原领域,基于偏微分方程(PDE)的建模方法被广泛应用,如Perona-Malik方程通过各向异性扩散实现边缘保持的平滑,有效克服了传统高斯滤波导致的边缘模糊问题,在图像分割研究中,水平集(Level Set)方法通过隐式函数曲线演化,能够处理拓扑结构变化的目标分割,其数学基础为曲线论和变分法,小波变换凭借时频局部化特性,在图像去噪与压缩中实现了多尺度分析,通过构造小波基函数(如Daubechies系、Symlet系),将图像信号分解为不同频带的子带,再通过阈值处理(如软阈值、硬阈值)去除噪声分量,统计建模方法则通过概率分布描述图像特征,如高斯混合模型(GMM)用于背景建模与运动目标检测,马尔可夫随机场(MRF)结合贝叶斯理论实现图像分割与超分辨率重建,这些方法为图像不确定性问题的解决提供了数学框架。

算法设计与优化方法

算法设计是数字图像处理研究的核心环节,当前研究主要集中在传统算法改进、智能算法融合及高效实现三个方向,传统算法方面,以卷积操作为核心的图像滤波算法(如中值滤波、双边滤波)通过优化窗口策略或权重计算方式提升处理效果,例如快速双边滤波通过降维技术将时间复杂度从O(n²)降至O(n),适用于实时处理场景,智能算法融合方面,深度学习技术彻底改变了图像处理的研究范式,卷积神经网络(CNN)通过多层卷积与池化操作自动学习图像特征,在图像分类(如ResNet、VGG)、目标检测(如Faster R-CNN、YOLO)和语义分割(如U-Net、DeepLab)中取得突破性进展;生成对抗网络(GAN)则通过生成器与判别器的对抗训练,实现图像超分辨率、风格迁移等任务,如SRGAN网络将低分辨率图像重建为高分辨率细节丰富的图像,在算法优化方面,针对硬件平台特性(如GPU、FPGA)的并行化改造成为研究热点,通过CUDA编程实现CNN的矩阵运算并行化,或通过量化技术(如8位量化)减少模型参数量,提升算法在边缘设备上的部署效率。

实验验证与性能评估方法

实验验证是确保图像处理算法有效性的关键环节,需构建标准化的测试流程与评估体系,数据集选择方面,根据应用场景选取公开数据集(如ImageNet、PASCAL VOC用于目标检测,BSD500用于图像分割)或构建领域专用数据集(如医学影像中的BraTS脑肿瘤数据集),并确保数据覆盖不同光照、噪声、分辨率等条件以验证算法鲁棒性,评估指标需区分任务类型:图像质量评估采用峰值信噪比(PSNR)、结构相似性(SSIM)等客观指标,结合主观评价(如MOS评分)综合反映视觉感知效果;目标检测与分割任务则精确率(Precision)、召回率(Recall)、mAP(平均精度均值)等指标;实时性评估以帧率(FPS)为单位,衡量算法在特定硬件平台上的处理速度,消融实验(Ablation Study)通过逐步移除算法模块验证各组件的贡献,对比实验(如与传统算法、SOTA方法对比)凸显算法优势,确保研究结论的科学性与可信度。

系统实现与应用落地方法

数字图像处理研究的最终目标是实现技术落地,需结合工程实践构建完整的处理系统,硬件架构设计方面,根据应用需求选择计算平台:云端服务器采用GPU集群(如NVIDIA V100)支持大规模图像处理任务,边缘设备则通过嵌入式GPU(如Jetson Nano)或NPU实现低功耗实时处理,如自动驾驶系统中摄像头图像的预处理需在毫秒级完成,软件框架选择上,OpenCV作为经典开源库提供丰富的图像处理函数(如滤波、特征提取),PyTorch和TensorFlow则深度集成深度学习模型训练与部署工具链,简化算法开发流程,跨平台兼容性是系统实现的关键,需考虑操作系统(Windows/Linux/嵌入式系统)、编程语言(C++/Python)及硬件接口(如Camera Link、USB3.0)的适配,例如在医疗影像设备中,需确保DICOM格式图像的标准化处理与PACS系统兼容,系统安全性(如图像防篡改、隐私保护)与可靠性(如故障恢复、异常处理)也是应用落地的重要考量,通过加密算法(如AES)对敏感图像数据加密,或引入冗余设计保障系统稳定运行。

新兴交叉研究方向

随着技术融合,数字图像处理研究不断拓展至新领域,多模态图像处理通过融合可见光、红外、深度等多源图像信息,提升复杂场景下的感知能力,如自动驾驶中融合摄像头与激光雷达数据实现三维环境重建,图像与三维视觉结合方面,神经辐射场(NeRF)通过隐式函数表示三维场景,实现新视角图像合成,推动虚拟现实与数字孪生发展,可解释性AI成为深度学习图像处理的新方向,通过可视化卷积特征图(如Grad-CAM)解释模型决策依据,增强算法在医疗、安防等高风险领域的可信度,绿色图像处理通过算法优化降低能耗,如轻量化模型设计(如MobileNet、ShuffleNet)减少计算资源消耗,符合“双碳”背景下的技术发展趋势。

相关问答FAQs

Q1:数字图像处理中,传统算法与深度学习算法如何选择?

A1:选择传统算法还是深度学习算法需根据具体任务场景、数据量及硬件资源综合判断,传统算法(如基于滤波、分割的方法)具有模型简单、计算量小、可解释性强等优势,适用于数据量有限、实时性要求高或任务逻辑明确的场景(如工业质检中的边缘检测、医学影像中的简单阈值分割),深度学习算法则在大数据量、复杂特征提取任务中表现突出(如自然场景图像分类、医学影像病灶识别),但其依赖大量标注数据、模型训练成本高、计算资源需求大,且可解释性较差,在实际应用中,可采用“传统算法预处理+深度学习核心处理”的混合方案,例如先通过传统滤波去除图像噪声,再利用CNN进行目标检测,兼顾效率与精度。

Q2:如何评估数字图像处理算法的实时性?

A2:实时性评估需结合硬件平台与应用场景的具体指标,核心评估维度包括:单帧图像处理时间(单位:毫秒/帧)、帧率(FPS,即每秒处理图像帧数)及端到端延迟(从图像采集到结果输出的总时间),自动驾驶中摄像头图像处理需满足FPS≥30(即单帧处理时间≤33ms),而医疗影像分析可接受秒级延迟,测试方法需在目标硬件平台上进行,通过计时工具(如Python的time模块、OpenCV的getTickCount函数)测量算法关键模块耗时,分析计算瓶颈(如卷积运算、内存拷贝),需考虑多任务并发场景下的资源竞争(如CPU/GPU占用率),确保算法在高负载下仍能稳定运行,对于嵌入式设备,还需优化内存占用(如减少动态内存分配)和功耗,避免因资源过载导致系统崩溃。