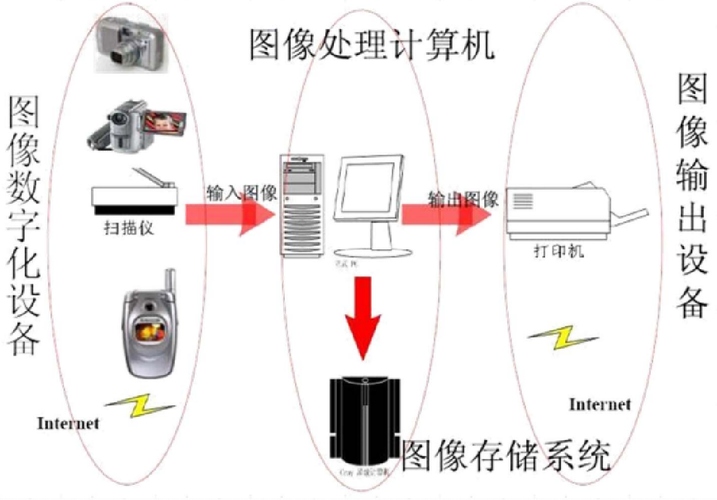

数字图像处理方法的研究是计算机视觉、模式识别、医学影像分析等领域的重要基础,其核心在于通过算法对图像信息进行提取、增强、复原、分割及识别等操作,以满足不同应用场景的需求,随着人工智能、大数据技术的快速发展,数字图像处理方法的研究已从传统的信号处理理论逐步融合深度学习、优化算法等新兴技术,形成了多层次、跨学科的研究体系,本文将从传统方法、现代方法及未来趋势三个维度,系统探讨数字图像处理方法的研究现状与关键技术。

传统数字图像处理方法及其应用

传统数字图像处理方法主要基于数学变换和统计模型,依赖人工设计的特征提取器,在特定领域仍具有不可替代的优势,其核心方法包括空域处理、频域处理及基于模型的算法等。

空域处理技术

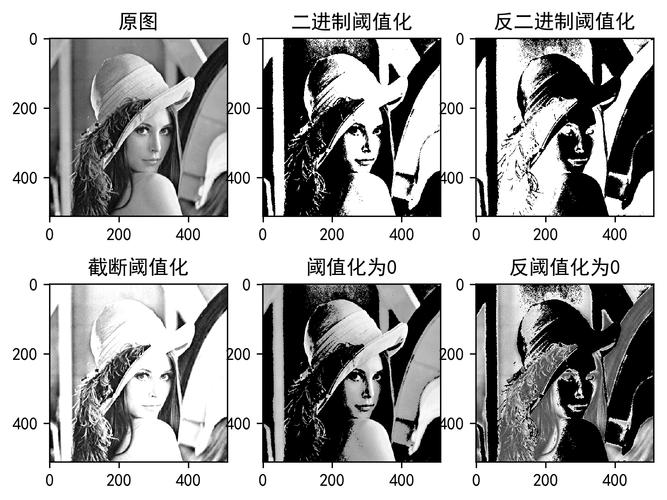

空域处理直接对图像像素进行操作,是最直观的处理方式,典型技术包括点运算(如灰度变换、直方图均衡化)和邻域运算(如均值滤波、中值滤波),直方图均衡化通过调整像素灰度分布增强图像对比度,广泛应用于医学影像和监控图像的增强;中值滤波则能有效去除椒盐噪声,同时保留图像边缘细节,形态学处理(如腐蚀、膨胀、开闭运算)在二值图像处理中表现突出,可用于目标提取和结构特征分析。

频域处理技术

频域处理通过傅里叶变换、离散余弦变换(DCT)等将图像从空间域转换到频率域,实现噪声滤除、压缩等操作,傅里叶变换可将图像分解为不同频率的分量,便于去除高频噪声或增强特定纹理特征;DCT则是JPEG图像压缩的核心,通过将图像能量集中在低频系数实现数据压缩,小波变换作为一种多尺度频域分析方法,兼具时频局部化特性,在图像去噪和边缘检测中优于传统傅里叶变换。

基于模型的分割与识别方法

图像分割是目标识别的前提,传统方法包括阈值分割(如Otsu法)、区域生长法及边缘检测(如Canny算子),阈值分割通过设定灰度阈值将图像分为目标与背景,适用于灰度分布明显的图像;区域生长法则从种子点出发,根据像素相似性逐步合并区域,适合复杂结构的分割,在识别阶段,特征提取(如SIFT、HOG)与分类器(如SVM、AdaBoost)结合,构成传统图像识别流程,尽管依赖人工特征设计,但在小样本场景下仍具稳定性。

现代数字图像处理方法:深度学习的驱动

近年来,深度学习技术的突破推动了数字图像处理方法的革新,其端到端的学习模式显著提升了复杂任务的性能,卷积神经网络(CNN)作为核心架构,在图像分类、目标检测、语义分割等任务中取得突破性进展。

卷积神经网络(CNN)的发展

CNN通过局部感受野、权值共享和池化操作,有效提取图像的层次化特征,LeNet-5作为早期CNN模型,奠定了手写数字识别的基础;AlexNet通过ReLU激活函数和Dropout技术,在ImageNet竞赛中大幅刷新纪录;VGGNet和GoogLeNet则通过堆叠小卷积核或引入Inception模块,深化网络结构并提升计算效率;ResNet提出的残差连接解决了深层网络的梯度消失问题,使网络层数突破百层,这些模型的发展推动了图像识别准确率的显著提升,例如ImageNet分类错误率从2012年的26%降至2025年的不足1%。

生成对抗网络(GAN)与图像生成

GAN由生成器和判别器组成,通过对抗训练实现图像生成与风格迁移,StyleGAN可生成高真实度的人脸图像,广泛应用于数据增强和虚拟现实;Pix2Pix通过条件GAN实现图像到图像的转换,如卫星地图到遥感影像的翻译,GAN在图像超分辨率重建(如ESRGAN)和图像修复领域表现出色,能够恢复低分辨率图像的细节或填补缺失区域。

注意力机制与Transformer架构

注意力机制通过赋予不同特征区域不同权重,提升模型对关键信息的捕捉能力,SENet(Squeeze-and-Excitation Network)通过通道注意力增强特征表示;Transformer架构则源于自然语言处理,其自注意力机制在图像分类(如ViT)和目标检测(如DETR)中展现出强大的全局建模能力,相比CNN,Transformer更适合处理长距离依赖关系,但在数据量需求上高于传统模型。

数字图像处理方法的关键技术挑战

尽管数字图像处理技术取得了显著进展,但仍面临诸多挑战,主要包括以下几个方面:

小样本与跨域泛化能力

实际应用中,标注数据往往有限,且不同场景下的图像分布差异(如光照、角度变化)会导致模型泛化性能下降,为解决这一问题,研究者提出了迁移学习(如预训练模型微调)、元学习(如MAML算法)及无监督域适应(如DANN)等方法,旨在提升模型在数据稀缺或跨场景下的适应能力。

实时性与计算效率

在自动驾驶、医疗影像实时分析等场景中,算法的实时性至关重要,传统CNN计算复杂度高,难以部署在资源受限设备上,为此,轻量化网络设计成为研究热点,如MobileNet通过深度可分离卷积减少参数量,ShuffleNet引入通道混洗提升特征流动性;模型压缩技术(如剪枝、量化、知识蒸馏)则能在保持性能的同时降低计算开销,满足边缘设备的部署需求。

鲁棒性与对抗攻击防御

深度学习模型易受对抗样本攻击,即通过添加人眼难以察觉的扰动导致模型误判,FGSM攻击可生成使分类器错误的高对抗样本,为提升模型鲁棒性,研究者提出了对抗训练(如PGD攻击训练)、输入预处理(如随机裁剪)及模型正则化等方法,可解释性技术(如Grad-CAM)有助于分析模型决策依据,增强系统安全性。

数字图像处理方法的未来发展趋势

未来数字图像处理方法的研究将呈现多技术融合、多领域交叉的特点,主要趋势包括:

多模态融合与跨媒体理解

随着图像、文本、语音等多模态数据的普及,跨媒体理解成为重要方向,CLIP模型通过对比学习实现图像与文本的联合嵌入,支持零样本分类;多模态Transformer(如ViLBERT)能够同时处理视觉与语言信息,推动视觉问答、图文生成等任务的发展,多模态融合将在智能医疗(如影像与病历分析)、自动驾驶(如视觉与传感器数据融合)等领域发挥更大作用。

自监督学习与无标注数据利用

标注数据的成本限制了模型性能的提升,自监督学习通过设计代理任务从未标注数据中学习特征表示,成为解决这一问题的关键,SimCLR通过对比学习增强图像特征;MAE(Masked Autoencoders)通过掩码图像重建预训练视觉Transformer,自监督学习有望减少对标注数据的依赖,推动大规模图像数据的利用。

脑启发计算与类脑视觉系统

借鉴人类视觉系统的层次化、稀疏性及动态注意力机制,脑启发计算为图像处理提供了新思路,脉冲神经网络(SNN)利用脉冲信号传递信息,具有低功耗、高动态范围的特点;神经形态计算则通过模拟神经元结构实现高效信息处理,类脑视觉系统或将在实时目标跟踪、动态场景理解等场景中实现突破。

相关问答FAQs

问题1:传统数字图像处理方法与深度学习方法的主要区别是什么?

解答:传统方法依赖人工设计的特征提取器和数学模型(如滤波器、变换域分析),计算效率较高但泛化能力有限,需针对特定任务调整算法参数;深度学习方法通过端到端学习自动提取特征,无需人工设计,对复杂场景(如光照变化、遮挡)的适应性强,但需要大量标注数据和较高计算资源,传统方法在数据量小、实时性要求高的场景仍具优势,而深度学习方法在大规模数据和高精度任务中表现更优。

问题2:如何解决数字图像处理中实时性与精度的平衡问题?

解答:平衡实时性与精度需从模型设计、算法优化及硬件部署三个层面入手,模型设计上,采用轻量化网络(如MobileNet、ShuffleNet)或模型压缩技术(如剪枝、量化)减少参数量和计算复杂度;算法优化上,通过知识蒸馏(用大模型指导小模型训练)或动态计算(如Early Exit)在保证精度的前提下提前终止推理;硬件部署上,利用GPU、TPU或专用AI芯片加速计算,同时结合边缘计算框架(如TensorFlow Lite)实现低延迟处理,实际应用中,可根据场景需求调整三者权重,例如在自动驾驶中优先保证实时性,在医疗影像中侧重精度。